高まるAIのニーズ

生産性の向上や労働の過度な負担改善などが期待できることから、あらゆる分野でAIの応用が期待されています。AIには強力な演算処理能力が求められますが、この能力を満たすためにGPUが演算装置として利用されています。SCSKでは、GPUを搭載する各種AIサーバーを用意しています。

AIサーバー導入のメリット

GPUがAIに使われている理由は、高い並列計算能力にあります。本来はパソコンなどの描画を行うグラフィックスボードの主要部品でしたが、並列処理が得意で同じような計算を高速で繰り返すことができます。一方、CPUほど複雑で多様な処理はできません。しかし、GPUの演算能力の特性が、高速な並列処理が求められるAIの開発に適しています。

NVIDIA DGXシリーズは、GPU性能を最大限に引き出し、AIのワークフローに対応することができます。SCSKが推奨するHPE ProLiantシリーズおよびHPE Cray XDシリーズにNVIDIA製GPUを搭載するサーバーは、ベースに汎用のIAサーバーを利用することによって、高い信頼性とリプレースの自由度を両立することができます。

GPU搭載AIサーバー導入によって可能になること

(1)製品設計

製品の3Dモデリングやシミュレーションを行う際、複雑な計算を高速に処理します。これにより、設計者はリアルタイムで設計の調整や最適化を行うことができます。

(2)品質保証

AIを利用した自動検査システムで、製品の欠陥を高速に検出します。これにより、生産ラインでの不良品の出荷を防ぎ、品質の高い製品を提供することが可能になります。

(3)予測メンテナンス

AIを利用した予測メンテナンスシステムで大量のセンサーデータを解析し、機械の故障を予測します。これにより、予期せぬダウンタイムを防ぎ、生産効率の向上が可能になります。

(4)生産計画の最適化

需要予測やリソースの最適な配分など、複雑な問題を迅速に解決します。

(5)在庫管理

AIを利用した在庫管理システムでは、過去の販売データや現在の在庫状況などを基に、必要な製品の量を高速に計算します。これにより、在庫の過剰または不足を防ぐことができます。

【導入にあたって】 AI対応GPUの選択ポイント

AIのためのGPU選択には、次のポイントがあります。

-

コスト

GPUそのもののコストも重要ですが、GPUを搭載するサーバーのコストも重要です。導入費用だけでなく、ランニングコストにも注意を向ける必要があります。

-

コア数

CPUのマルチコアはよく知られていますが、GPUは少し事情が違います。CPUは1つのプロセッサに数個程度のコアを備えていますが、GPUの場合は数千個のコアになります。

-

メモリ容量とメモリ帯域

GPUは、メモリ容量とメモリ帯域で能力が決まります。メモリの容量が大であれば、より大規模なAIモデルを処理できます。メモリ帯域が広ければ処理が高速になります。

-

発熱/冷却処理性能

GPUの課題に発熱があります。高速の並列処理を行うために発熱が膨大で、冷却の問題がつきまといます。冷却の問題が解決されているシステム構成を選択することが重要です。

-

消費電力

GPUは、高速の並列処理を行うため電力消費が大きくなりやすい傾向があります。サーバー側にGPUを多数搭載できるスペックがあったとしても、電力がまかなえない場合もありえます。電力問題が解決されているシステム構成を選択する必要があります。

以上のような課題は、SCSKにお任せください。用途・目的にあったAIサーバーを用意しています。

AIに最適なNVIDIAのGPU

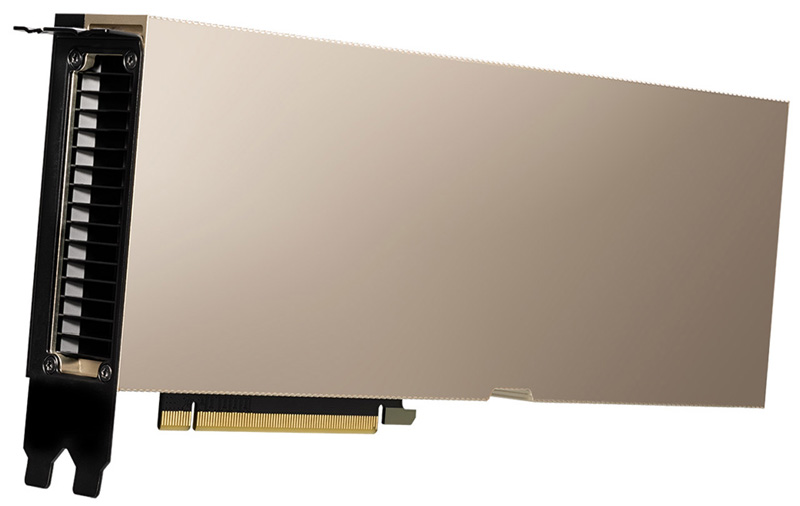

NVIDIA A100 TensorコアGPU

A100は、2TB/秒を超える最速のメモリ帯域幅を誇り、最大規模のモデルとデータセットを実行できます。ハードウエア、ネットワーキング、ソフトウエア、ライブラリ、最適化されたAIモデル、NVIDIA NGC※のアプリケーションにわたる構成要素を組み込んでいます。パワフルなAI/HPC用エンド・ツー・エンド・プラットフォームであり、ソリューションを大規模な運用環境に展開できます。

※NVIDIA NGC:企業向けのサービス、ソフトウエア、管理ツール、サポートでAIとデジタルツインのエンド・ツー・エンド・ワークフローを支援するポータル

NVIDIA A100のスペック

| フォームファクター | A100 80GB PCIe | A100 80GB SXM |

|---|---|---|

| FP64 | 9.7TFLOPS | |

| FP64 Tensorコア | 19.5TFLOPS | |

| FP32 | 19.5TFLOPS | |

| Tensor Float 32 (TF32) | 156TFLOPS | 312TFLOPS* | |

| BFLOAT16 Tensorコア | 312TFLOPS | 624TFLOPS* | |

| FP16 Tensorコア | 312TFLOPS | 624TFLOPS* | |

| INT8 Tensorコア | 624TOPS | 1248TOPS* | |

| GPUメモリ | 80GB HBM2e | 80GB HBM2e |

| GPUメモリ帯域幅 | 1,935GB/秒 | 2,039GB/秒 |

| 最大熱設計電力(TDP) | 300W | 400W*** |

| マルチインスタンスGPU | 最大7基のMIGs @ 10GB | 最大7基のMIGs @ 10GB |

| フォームファクター | PCIe デュアルスロット空冷 または デュアルスロット液冷 |

SXM |

| 相互接続 | NVIDIA NVLink Bridge ブリッジ 2GPU用:600GB/秒** PCIe Gen4:64GB/秒 |

NVLink:600GB/秒 PCIe Gen4:64GB/秒 |

| サーバーオプション | 1~8GPU搭載のパートナー および NVIDIA-Certified Systems | NVIDIA HGX A100 - 4、8、16GPU搭載のパートナー および NVIDIA-Certified Systems 8GPU搭載のNVIDIA DGX A100 |

- * 疎性あり

- ** HGX A100サーバーボードを経由したSXM4 GPU; NVLinkブリッジ経由のPCIe GPU(最大2基のGPU向け)

- *** 標準構成でTDP 400W。HGX A100-80GBのカスタムサーマルソリューション(CTS)SKUは、最大500WのTDPに対応可能です。

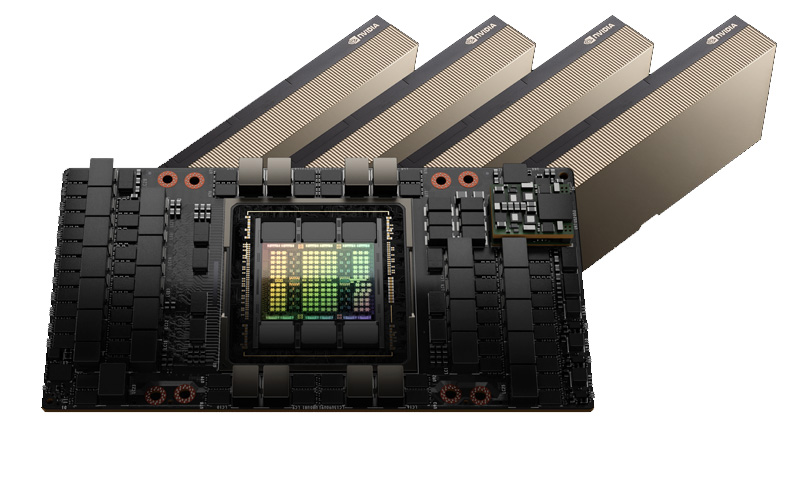

NVIDIA H100 TensorコアGPU

H100は、アクセラレーテッド・コンピューティングの神髄です。NVIDIA NVLink Switch Systemにより、最大256個のH100を接続し、エクサスケールのワークロードを高速化できます。さらに、専用のTransformer Engineを利用することで、パラメーターが兆単位の言語モデルを実装できます。

最大1750億パラメーターの大規模言語モデル(LLM)の場合、PCIeベースのH100 NVL with NVLinkブリッジは、Transformer Engine、NVLink、および188GB HBM3メモリを利用して、最適な性能と容易な拡張性を提供します。H100 NVL GPUを搭載したサーバーは、電力制約のあるデータセンター環境において低遅延を維持しながら、GPT-175Bモデルの性能をNVIDIA DGX A100システムの最大12倍まで向上します。

NVIDIA H100のスペック

| フォームファクター | H100 SXM | H100 PCIe | H100 NVL(*2) |

|---|---|---|---|

| FP64 | 34teraFLOPS | 26teraFLOPS | 68teraFLOPs |

| FP64 Tensorコア | 67teraFLOPS | 51teraFLOPS | 134teraFLOPs |

| FP32 | 67teraFLOPS | 51teraFLOPS | 134teraFLOPs |

| TF32 Tensorコア | 989teraFLOPS* | 756teraFLOPS* | 1,979teraFLOPs* |

| BFLOAT16 Tensorコア | 1,979teraFLOPS* | 1,513teraFLOPS* | 3,958teraFLOPs* |

| FP16 Tensorコア | 1,979teraFLOPS* | 1,513teraFLOPS* | 3,958teraFLOPs* |

| FP8 Tensorコア | 3,958teraFLOPS* | 3,026teraFLOPS* | 7,916teraFLOPs* |

| INT8 Tensorコア | 3,958TOPS* | 3,026TOPS* | 7,916TOPS* |

| GPUメモリ | 80GB | 80GB | 188GB |

| GPUメモリ帯域幅 | 3.35TB/s | 2TB/秒 | 7.8TB/s(*1) |

| デコーダー | 7NVDEC 7JPEG |

7NVDEC 7JPEG |

14NVDEC 14JPEG |

| 最大熱設計電力(TDP) | 最大700W(構成可能) | 300~350W(構成可能) | 2×350-400W(構成可能) |

| マルチインスタンGPU | 最大7個のMIG @ 10GB | 各12GBの最大14のMIG | |

| フォームファクター | SXM | PCIe デュアルスロット空冷 |

2×PCIe デュアルスロット空冷 |

| 相互接続 | NVLink:900GB/秒 PCIe Gen5:128GB/秒 |

NVLINK:600GB/秒 PCIe Gen5:128GB/秒 |

NVLink:600GB/秒 PCIe Gen5:128GB/s |

| サーバーオプション | 4または16GPU搭載のNVIDIA HGX H100パートナー および NVIDIA-Certified Systems 8GPU搭載 NVIDIA DGX H100 | 1~8GPU搭載のパートナー および NVIDIA-Certified Systems | 2-4組のパートナー および NVIDIA-Certified Systems |

| NVIDIA AI Enterprise | アドオン | 含む | アドイン |

- * 疎性あり

- (*1) HBM帯域幅の総計

- (*2) 参考仕様。仕様は変更される場合があります。H100 NVL PCIeカード2枚とNVLink Bridgeを組み合わせた場合の仕様です。

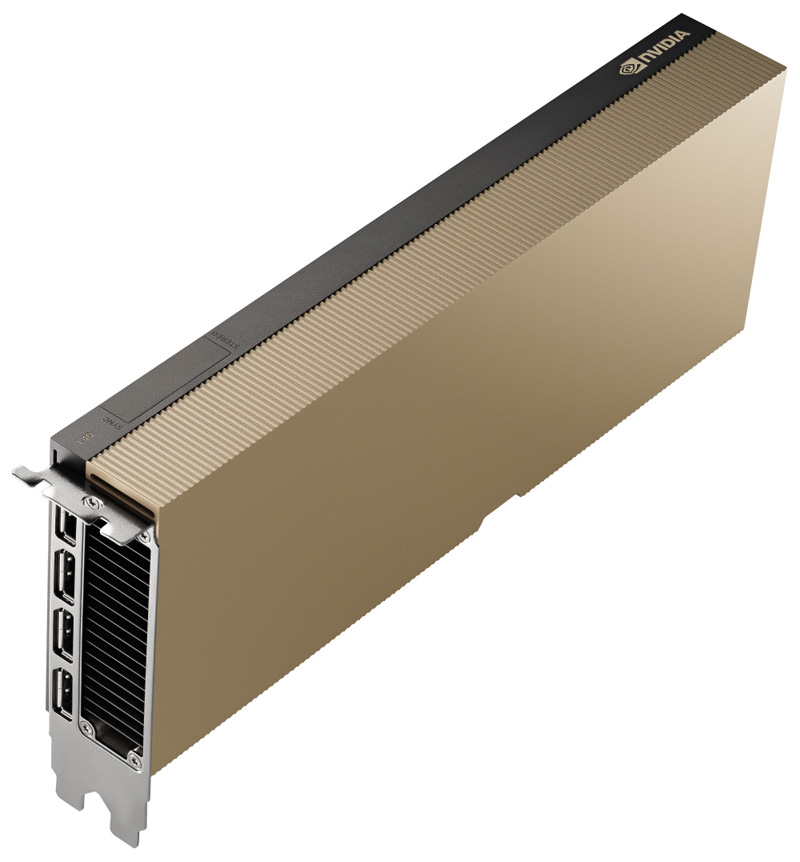

NVIDIA L40S GPU

L40Sは、データセンター用途において比類のないAIとグラフィックスのパフォーマンスを発揮します。第4世代Tensorコアと最適化されたTF32フォーマットのハードウエアサポートにより、AIおよびデータサイエンスモデルのトレーニングを高速化します。

第3世代RTコアは、スループットの向上、レイトレーシングとシェーディングの同時実行機能によって、パフォーマンスが向上しています。レイトレーシングのパフォーマンスとレンダリングの高速化は、エンジニアリングや建設関連のワークフロー、ハードウエアアクセラレーションによるモーションブラーによって、実物に迫るリアルタイムアニメーションを実現します。Transformer Engineは、AIパフォーマンスを劇的に加速し、トレーニングと推論の両方に利用できます。

L40Sは、データセンター対応します。エンタープライズデータセンターの24時間年中無休の運用向けに最適化されており、NVIDIAによって構築、テスト、サポートされ、最大限のパフォーマンス、耐久性を実現しています。 最新のデータセンター基準を満たしており、Network Equipment Building System(NEBS)レベル3に対応し、rootによるセキュアブート機能を備えています。信頼性の高い技術により、データセンターに一層のセキュリティを提供します。

NVIDIA L40Sのスペック

| GPUアーキテクチャ | NVIDIA Ada Lovelaceアーキテクチャ |

|---|---|

| GPUメモリ | 48GB GDDR6(ECC搭載) |

| メモリ帯域幅 | 毎秒864GB |

| 相互接続インターフェース | PCIe Gen4 ×16:毎秒64GB双方向 |

| NVIDIA Ada LovelaceアーキテクチャベースのCUDAコア | 18,176 |

| NVIDIA 第3世代RTコア | 142 |

| NVIDIA 第4世代Tensorコア | 568 |

| RTコアパフォーマンス TFLOPS | 212 |

| FP32 TFLOPS | 91.6 |

| TF32 Tensorコア TFLOPS | 183 | 366* |

| BFLOAT16 Tensorコア TFLOPS | 362.05 | 733* |

| FP16 Tensorコア | 362.05 | 733* |

| FP8 Tensorコア | 733 | 1,466* |

| ピーク INT8 Tensor TOPS ピーク INT4 Tensor TOPS |

733 | 1,466* 733 | 1,466* |

| フォームファクター | 4.4"(H)×10.5"(L)、デュアルスロット |

| Display Ports | 4×DisplayPort 1.4a |

| 最大消費電力 | 350W |

| 電源コネクタ | 16ピン |

| サーマル | パッシブ |

| 仮想GPU(vGPU)ソフトウエアサポート | あり |

| サポートされているvGPUプロファイル | 仮想** |

| NVENC | NVDEC | 3× | 3×(AV1エンコード/デコードを含む) |

| 信頼の基点(Root of Trust)によるSecure Boot | あり |

| NEBS Ready | レベル3 |

| マルチインスタンスGPU(MIG)サポート | なし |

| NVIDIA NVLinkサポート | なし |

- * 疎性あり

- ** GPUライセンスガイドを見る

SCSKでは、GPUを搭載する各種AIサーバーを用意しています。

GPU性能を極限まで引き出したいなら…… NVIDIA DGXシリーズへ

システム構成の汎用性と自由度を求めるなら…… HPE ProLiant/Cray XDシリーズへ