エンタープライズAIの標準

エンタープライズAIのために構築されたNVIDIA DGXプラットフォームは、NVIDIAのソフトウエア、インフラストラクチャ、および専門知識を硬度に統合し、クラウドからオンプレミスデータセンターまで、最新のAI開発ソリューションを提供します。

AI開発をリードするプラットフォーム

クラウドとオンプレミスをシームレスに連携するハードウエアとソフトウエアのAIプラットフォームです。DGXインフラストラクチャには、学習済みモデル、最適化されたフレームワーク、高速化されたデータサイエンスソフトウエアライブラリのためのNVIDIA AI Enterpriseソフトウエアも含まれています。これらにより、生産性の向上が可能になります。

NVIDIA AIの専門知識を活用

1つのプラットフォームに統合されたNVIDIA最高レベルのソフトウエアとハードウエアを活用し、AIワークロードの最適化を支援するNVIDIA DGXpertsに直接アクセスすることができます。これにより、迅速に成果とROIを実現できます。

比類のない性能と予測可能なコスト

DGX Cloud、オンプレミス、ハイブリッドのいずれで作業する場合でも、最先端の性能とエネルギー効率を実現します。DGXプラットフォームは、AIインフラの明瞭かつ予測可能なコストモデルを提供します。

NVIDIA DGX プラットフォーム

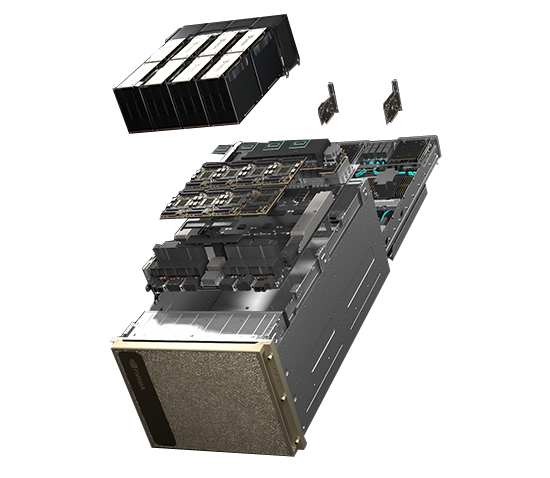

NVIDIA DGX H100 ―エンタープライズAI向けとして最善の選択肢―

DGX Systemsの最新バージョンです。DGX H100は、NVIDIA DGX SuperPODの基盤となっているNVIDIA H100 TensorコアGPUの画期的なパフォーマンスによってもたらされるAI対応の高性能製品です。

世界初の専用AIインフラストラクチャ

DGX H100は、世界初の専用AIインフラストラクチャの第4世代であり、完全に最適化されたハードウエアおよびソフトウエアプラットフォームです。新しいNVIDIA AIソフトウエアソリューションに対応し、多様なサードパーティのサポートを受けられるエコシステムを利用できます。NVIDIAプロフェッショナルサービスにより、エキスパートからのアドバイスを受けることが可能です。

大規模なワークロードに対応可能

DGX H100は6倍高速なパフォーマンス、2倍高速なネットワーキング、およびハイスピードなスケーラビリティをNVIDIA DGX SuperPODに対して発揮します。この次世代アーキテクチャは、自然言語処理やディープラーニングによるレコメンデーションモデルといった大規模なワークロードに対応可能です。

思いのままに使えるインフラストラクチャ

DGX H100は、オンプレミスにインストールして直接管理したり、NVIDIA DGX対応のデータセンターでの設置、NVIDIA認定のマネージドサービスプロバイダーを通じてアクセスすることもできます。また、DGX対応のライフサイクル管理により、予測性の高い財務モデルを入手して、最先端のデプロイメントを維持できます。

DGX H100の詳細

- NVIDIA H100 GPU×8、合計GPUメモリ640GB GPUあたり18NVIDIA NVLinks、GPU間の双方向帯域幅900GB/秒

- 4基のNVIDIA NVSwitch 7.2TB/秒のGPU間双方向帯域幅、前世代比1.5倍以上

- NVIDIA ConnectX-7×8およびNVIDIA BlueField DPU 400Gb/秒ネットワークインターフェース×2 ピーク時の双方向ネットワーク帯域幅1TB/秒

- デュアル×86CPUと2TBシステムメモリ AIへの依存が非常に高い仕事を可能にするパワフルなCPU

- 30TB NVMe SSD 最高のパフォーマンスを実現するための高速ストレージ

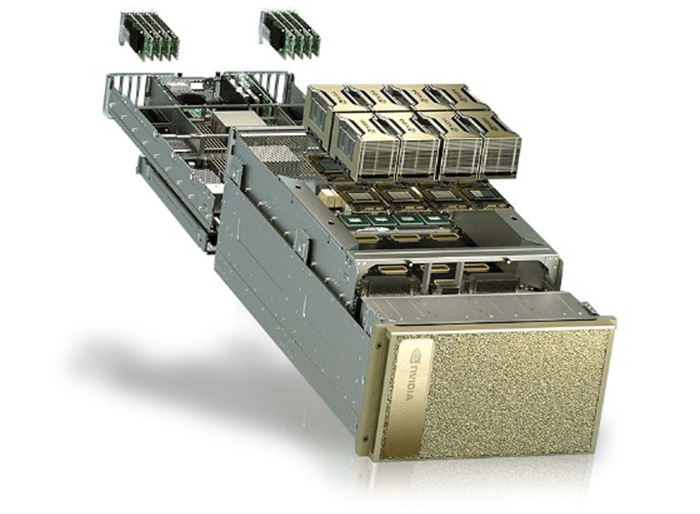

NVIDIA DGX A100 ―AIインフラストラクチャ向けのユニバーサルシステム―

あらゆるAIワークフローに対応するユニバーサルシステムで、前例のない計算処理密度、パフォーマンス、柔軟性を提供する世界初の5ペタフロップスAIシステムです。DGX A100は、 NVIDIA A100 TensorコアGPUを備えており、トレーニング、推論、分析を簡単に行え、NVIDIA AIエキスパートへの直接アクセスが含まれるAIインフラストラクチャに統合できます。

すべてのAIワークフローのためのユニバーサルシステム

NVIDIA DGX A100は、分析からトレーニング、推論に至るまで、あらゆるAIインフラストラクチャのためのユニバーサルシステムです。6Uのフォームファクタに5ペタフロップスのAIパフォーマンスを詰め込み、計算処理密度の新しい基準を提供します。

DGXperts:AI の専門知識への統合的アクセス

NVIDIA DGXpertsは、お客様によるDGX投資への価値を最大化できる世界的なチームです。このチームは、過去10年間にわたり豊富な経験を積んできた、AIに精通した専門家20000人超に達します。

世界初のAIシステム

NVIDIA DGX A100は、NVIDIA A100 TensorコアGPUをベースに開発された世界初のAIシステムです。320GBと640GBのGPUメモリオプションを持つ8基のA100 GPUを統合したこのシステムは高速化を実現し、NVIDIA CUDA-XソフトウエアとエンドツーエンドのNVIDIAデータセンターソリューションスタック用に完全に最適化されています。

Mellanoxネットワーキングを内蔵

NVIDIA DGX A100は、ピーク時の双方向帯域幅が500GB/秒のMellanoxネットワーキングを内蔵しています。これは、スケーラブルAIインフラストラクチャのリファレンスアーキテクチャとなるNVIDIA DGX SuperPODなどの大規模AIクラスタの基本構成要素にDGX A100を据えるための重要な機能の1つです。

DGX A100の詳細

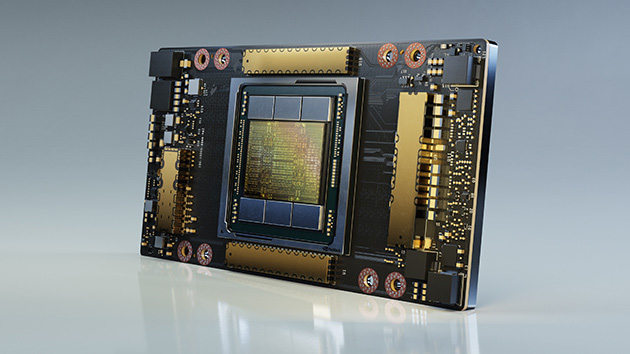

NVIDIA A100 TensorコアGPUによる高速化は、AI、データ分析、HPCなど、最も困難とされる計算に有効です。第3世代の NVIDIA Tensorコアによって性能を大幅に向上できるようになり、A100 GPUを効率的に数千までスケールアップできます。また、マルチインスタンスGPUを使用すれば、あらゆるサイズのワークフローを高速化するために7つの小さな専用インスタンスとして割り当てることができます。

- NVIDIA A100 GPU×8、合計GPUメモリ640GB 12 NVLinks/GPU、毎秒600GBのGPU-to-GPU双方向帯域幅

- 6基のNVIDIA NVSwitch 双方向の帯域幅:4.8TB/秒、前世代と比較して2倍

- 10基のMellanox ConnectX-6 200/Gbネットワークインターフェース ピーク時の双方向の帯域幅:500GB/秒

- 2基の64コアAMD CPUと2TBシステムメモリ 3.2倍のコアで負荷の高いAIジョブに対応

- 30TB Gen4 NVMe SSD 50GB/秒のピーク帯域幅、Gen3 NVMe SSDより2倍高速

NVIDIA DGX GH200 ―AIのための大容量メモリスーパーコンピューティング―

AIの兆パラメータ計測器

256個のNVIDIA Grace Hopper Superchipを単一のGPUに完全に接続する新しいクラスのAIスーパーコンピュータです。NVIDIA DGX GH200は、大規模なレコメンダーシステム、生成AI、グラフ分析などに対応したテラバイトクラスのモデルを処理できるように設計されています。巨大なAIモデルのための線形スケーラビリティを備えた144TBの共有メモリを提供します。

NVIDIA DGX SuperPOD ―AIの発展を見据えた専用設計―

世界初のすぐに使えるAIデータセンターソリューション

NVIDIA DGX SuperPODは、AIデータセンター基盤プラットフォームであり、あらゆるユーザーとワークロードに対して妥協のない性能を提供できます。DGX SuperPODは、AIおよびHPCの高度なワークロードに対して、業界最高水準のアクセラレーテッドインフラストラクチャと俊敏かつスケーラブルな性能を提供します。

NVIDIA DGX BasePOD ―エンタープライズAIのインフラクトラクチャ―

AI企業に変革をもたらす不可欠なインフラストラクチャ

AIは、ヘルスケア、製造、金融サービスまで、あらゆる産業における重要な業務で力を発揮します。NVIDIA DGX BasePODは、ビジネスの変革を実現し、AIアプリケーションを生み出す重要な基盤となります。DGX BasePODアーキテクチャは、パフォーマンス、スケール、管理性が実証されています。NVIDIA AI Enterpriseソフトウエアスイートは、業界向けにカスタマイズされたソフトウエアとツールを組み合わせることによって、AIアプリケーションをより迅速かつ優れた費用対効果で構築できます。

お問い合わせ・資料DL

NVIDIAソリューションに関するご相談や、各種資料ダウンロードはこちらから

SCSKでは、GPUを搭載する各種AIサーバーを用意しています。

システム構成の汎用性と自由度を求めるなら…… HPE ProLiant/Cray XDシリーズへ

[AI Server]トップに戻る…… NVIDIA AI対応GPU搭載サーバー