Kubernetesにおけるアラートのベストプラクティス

このテキストは、Kubernetesプラットフォームとオーケストレーションにおけるアラートのベストプラクティスについてのクックブックであり、PromQLアラートの例を含んでいます。

効果的なアラートシステムは監視戦略の基盤であり、Kubernetesへの移行に伴って進化する必要があります。

コンテナとコンテナオーケストレーターの追加、マイクロサービスアーキテクチャ、新しいスケールと集約の要件、および視認性の欠如は、監視方法の変化を必要とします。

アラートのベストプラクティスには、ホストやKubernetesノードレイヤー、Kubernetesインフラストラクチャ、サービス、アプリケーションレイヤーメトリクスのアラートが含まれます。

これらのアラートは、信頼性の高いインフラストラクチャを構築し、システム全体のスタックを理解する上で重要です。

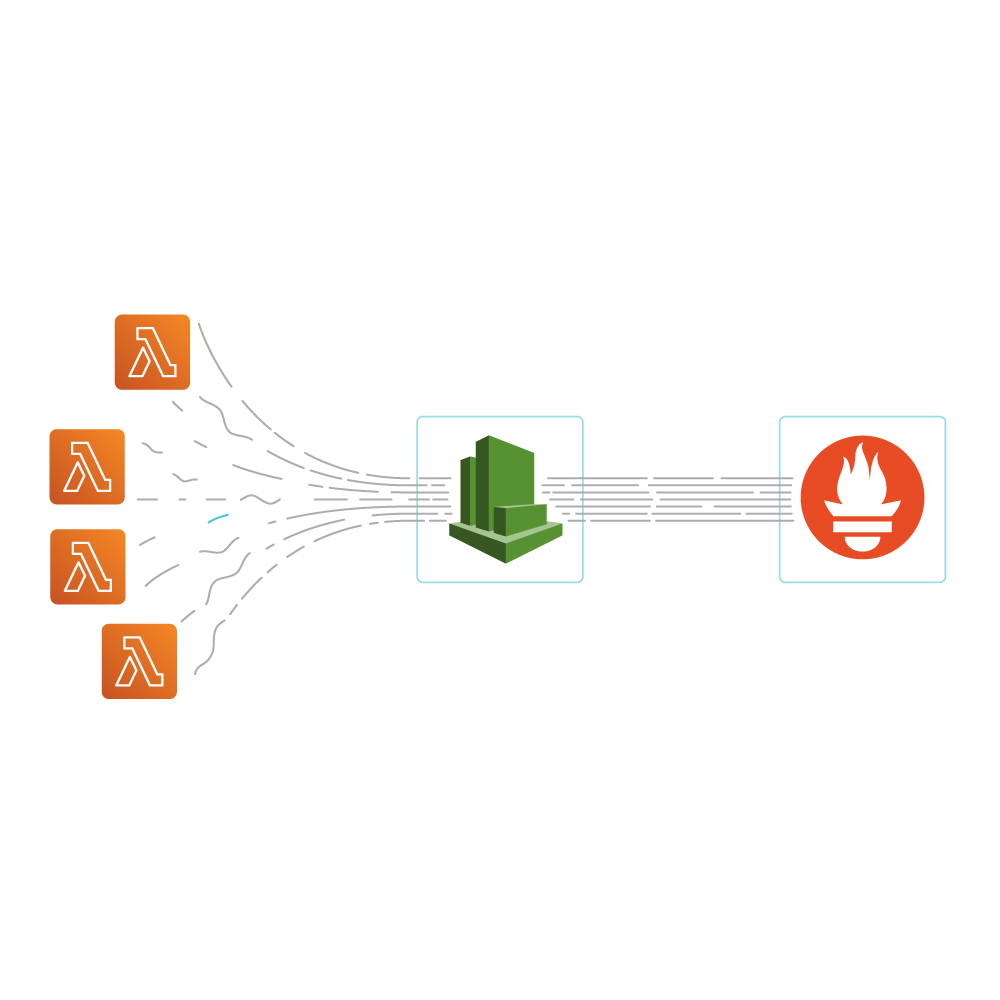

Sysdig Monitorは、これらのアラートを簡単に設定し、PromQLを使用して高度なアラートを作成する機能を提供します。