この記事では、Kubernetesのクラスターネットワークの正常性を保つために重要なコンポーネントであるkube-proxyの監視方法について説明しています。

kube-proxyは各ノードで動作し、ネットワークプロキシおよびロードバランサとして機能し、ポッド間や外部からの接続を管理します。

主に、Prometheusメトリクスを使用してkube-proxyの性能を監視することが推奨されており、デフォルトでは10249番ポートでこれらのメトリクスが公開されます。

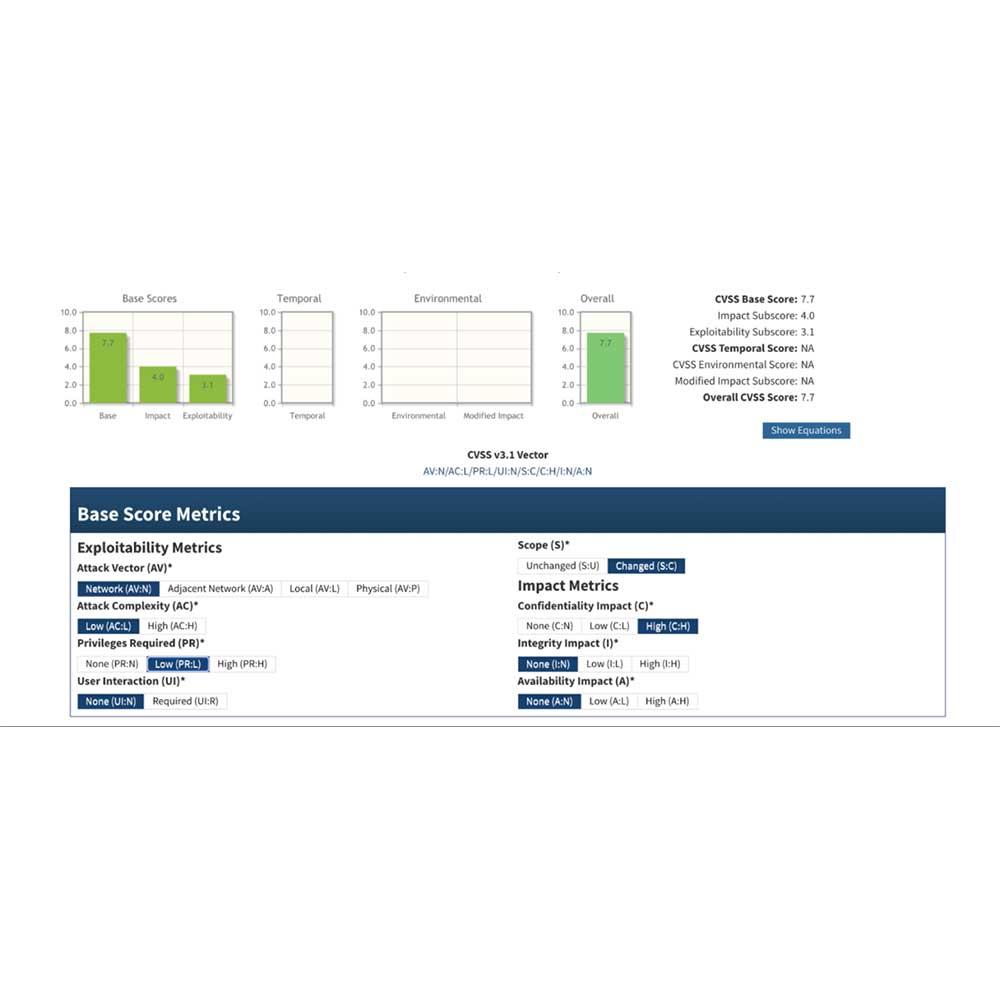

監視においては、レイテンシー、リクエスト数、エラー数、サチュレーションといったGolden Signalsに注目し、Kubernetesのバージョンに応じてメトリクスが異なることに注意が必要です。

Prometheusサーバーを使用してkube-proxyを監視設定に追加し、必要なメトリクスをフィルタリングする方法が提案されています。

これにより、クラスターネットワークの問題を迅速に検出し、対応することができます。