etcdを監視する方法

etcdの監視は、本番環境でKubernetesを効果的に運用するために欠かせません。

etcdはKubernetesコントロールプレーンの中心であり、クラスターの望ましい状態を保持する分散型Key-Valueデータベースです。

セキュリティ、高速性、信頼性が特徴で、シンプルなAPIを提供します。

監視により、サービスの正常性を確認し、インフラ全体に影響を及ぼす可能性のある問題を早期に検出できます。

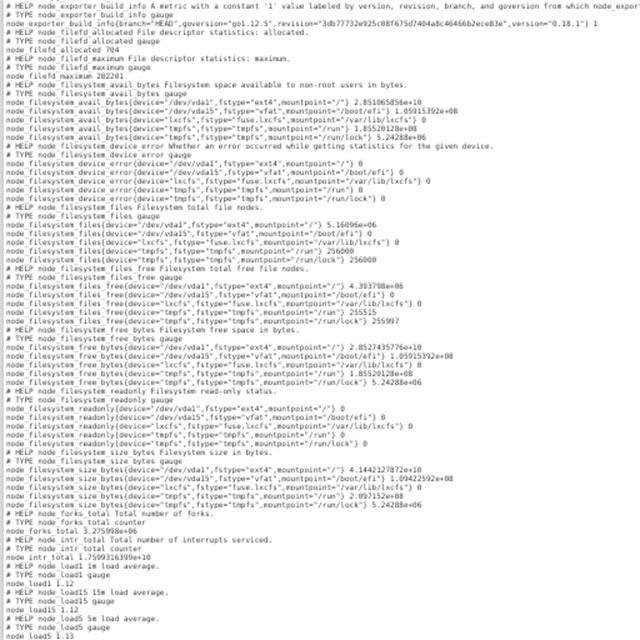

Prometheusを使用して、etcdから重要なメトリクスを収集し分析することが推奨されます。

これにより、etcdクラスターの健全性を評価し、適切なアラートを設定することが可能になります。

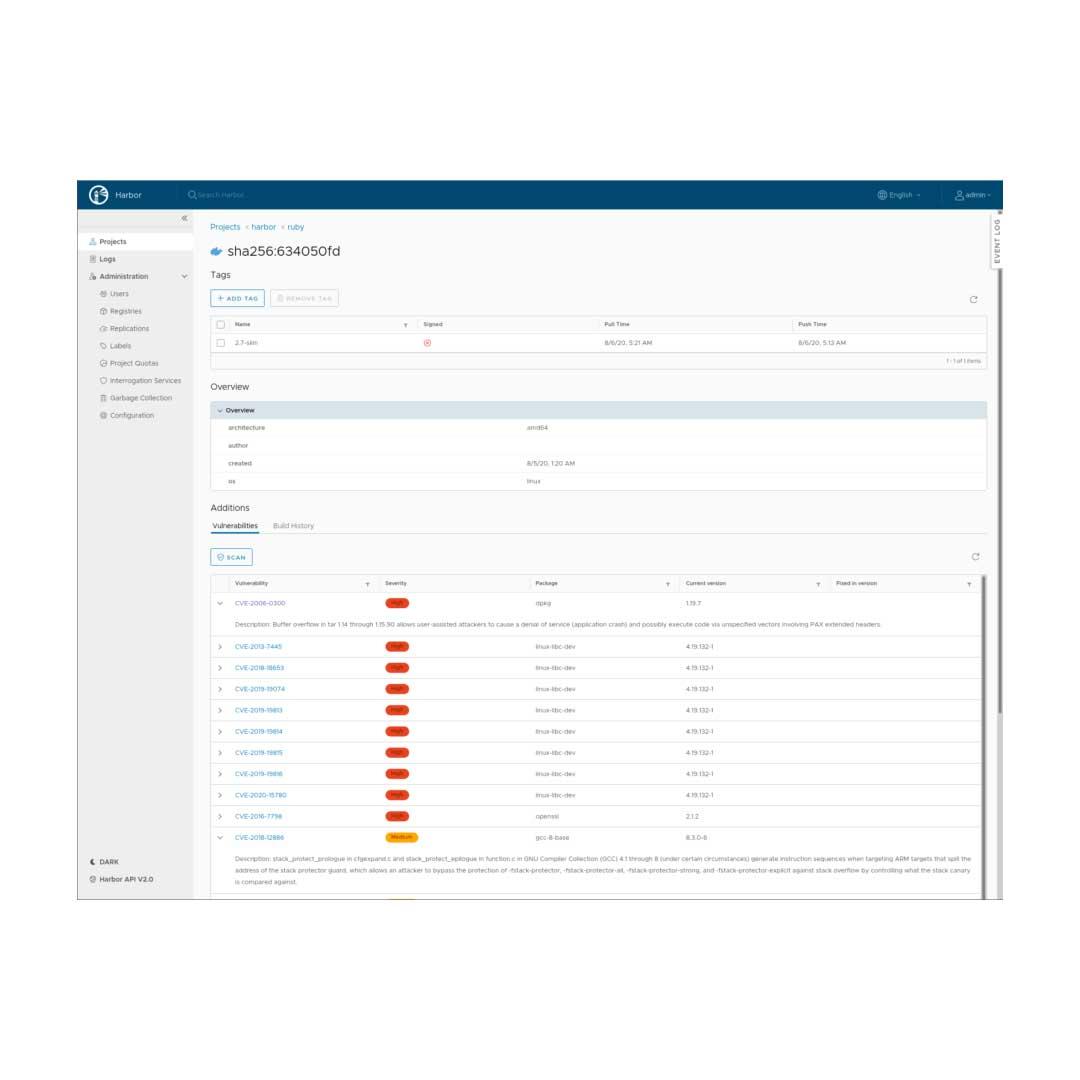

Sysdig Monitorを活用すれば、etcdの監視を簡単に設定し、クラスターの健全性を維持することができます。