NVIDIA GTC 2024イベントレポート ~Keynote(基調講演)から見る生成AIの世界~

- NVIDIA

- GTC

- イベントレポート

- ../../../article/2024/04/gtc2024.html

こんにちは、ITPNAVIの加藤です。この度SCSKでは、世界が注目する大企業NVIDIA社が開発するAI向けのスーパーコンピュータ「NVIDIA DGX H100」を検証機として導入しました。ディープラーニングや生成AIのビジネス活用が広がる中、NVIDIA DGX H100をはじめGPUコンピュータのニーズも高まっています。今回のカトウタイムズでは、NVIDIA DGX H100が設置されている「SCSK LINK SQUARE」へ実際に訪問し、NVIDIA社とSCSKが提供する最新のAIプラットフォームを徹底調査してまいりましたので、その全貌をレポートします。

【この記事を書いた人】ITPNAVI編集部 加藤優子

ITPNAVI編集部の加藤です!

連載「カトウタイムズ」でさまざまなIT関連の最新情報を、

SCSK社員である私の視点で皆様にお届けしています。

目次

「NVIDIA DGX(以下DGX)」は、GPUの性能を最大限に活用し、ディープラーニングをはじめとする大規模AI向けに開発されたスーパーコンピュータです。もともとGPUおよびGPUコンピュータはゲーミングなどのグラフィックス用途に使われていましたが、その特徴から現在ではAI分野でも欠かせない存在となっています。そこでNVIDIA社がAIに特化したGPUコンピュータとして2016年に打ち出したのがDGXです。DGXには、GPUおよびCPU、システムメモリといったハードウェアに加え、AI用途に最適化されたソフトウェアが事前にインストールされています。また、NVIDIA社のAIエキスパートによるサポートも含まれているため、企業がより手軽にそして素早く、AIの研究開発を進めることができます。

SCSK LINK SQUAREに設置されているNVIDIA DGX H100

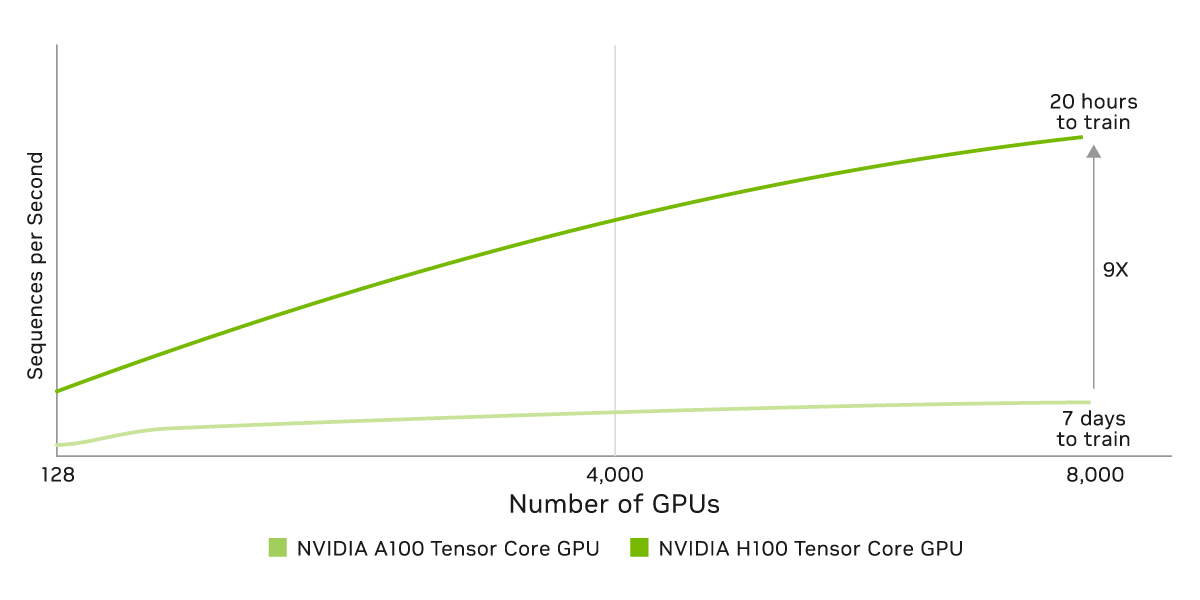

今回SCSKが導入した「NVIDIA DGX H100(以下H100)」とは、DGXシリーズの第4世代として2023年5月から日本国内で提供が開始されている最新かつ最大規模のスーパーコンピュータです。同じく現在提供されているなかでは最新のGPU「NVIDIA H100 TensorコアGPU」を8枚搭載し、「NVLink」と呼ばれる高速な通信プロトコルでそれぞれのGPUを繋ぐことによって、マルチGPUのリソースを効果的に発揮できます。一つ前の世代である「NVIDIA DGX A100」と比較しても、例えばAIトレーニングにおける性能は最大9倍と、圧倒的なパワーを誇っています。

NVIDIA A100 Tensorコア GPUとNVIDIA A100 Tensor コア GPUの比較

(出典:H100 Tensor コア GPU - NVIDIA)

さらにH100の特徴として、「NVIDIA AI Enterprise」に対応しており、ハードウェアとソフトウェアのパフォーマンスを最大化できる点も挙げられます(※後述)。こうした点から、LLMを含む生成AIなどの大規模なAIアプリケーションを開発するために、H100は欠かせない基盤となっています。

ロボットや AI/IoT による生産効率向上に関する研究を行っている航空宇宙生産技術開発センターでは、汎用外観検査AI の開発にH100を活用しています。

これまで外観検査AIというと、膨大な数の良品画像と不良品画像(つまり画像のみ)を学習させる手法が一般的でした。しかしこれでは検査対象の製品ごとに画像を用意しモデルの学習を行わなければならず、汎用性が低いという課題があります。そこで注目したのがマルチモーダルAI(テキスト、音声、画像など、異なるモーダル(データの種類・形態)の情報を統合して処理できるAI)です。画像に加え、言語によって良品・不良品の基準を例示して学習させることで、まるで人間のように、製品が変わっても汎用的に外観検査ができるようになります。

(出典・参考)DGX H100 が加速するマルチモーダル AI 開発 - ケース スタディ| NVIDIA

しかしマルチモーダルAIは扱うデータが増える分、コンピュータにはそれだけ高い演算性能が求められます。本プロジェクトではH100の導入により、従来使っていた前世代のA100と比べ、学習速度が4~5倍にも向上できました。

そんなH100が設置されているのは、東京(八重洲)にあるSCSKのブランディング拠点「SCSK LINK SQUARE(以下LINK SQUARE)」です。2024年6月に開設したばかりのLINK SQUAREは、SCSKの最新ソリューションやデジタル技術を体験できるエリアのほか、「夢ある未来を共に創る」という経営理念のもと、お客様やパートナーと共に新たなビジネスを共創する実証実験の場所として、社内外に広く開かれています。

SCSK LINK SQUAREのエントランス(左)とイベントエリア(右)

今回SCSKは、H100を自社だけでなく顧客と一緒に利用するための「検証機」として導入していますが、その意図はなんなのか、またなぜLINK SQUAREなのでしょうか。詳しく探っていきましょう。

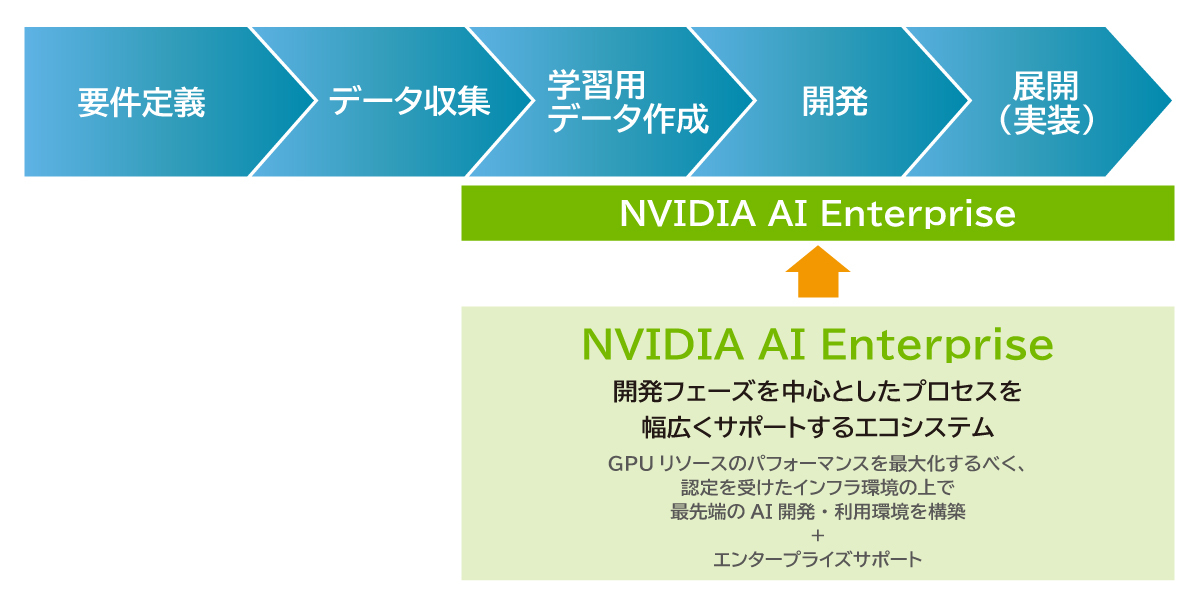

DGXおよびH100は、AI用途に特化したコンピュータであるとお伝えしました。生成AIの登場で近年急速にニーズが高まっているAIアプリケーションですが、その開発にあたってはさまざまな課題が山積しています。ここでは、一般的な開発プロセスの流れと、企業がAIプロジェクトを進めるにあたってどのような課題を抱えているのかを整理します。

AIアプリケーションの開発は下記のプロセスで進められます。

プロセス全体のイメージ

このうち、学習用データの作成・開発・展開(実装)プロセスにおいて、特にAIモデルが大規模で複雑なものになるほどGPUリソースが必要になるため、H100のような高性能なコンピュータが活用されます。

GPUコンピュータはあくまでハードウェアリソースであり、適切なスペックのものを用意すればそれだけで良いというわけではありません。むしろ、GPUコンピュータを活用してプロジェクトをどう進めるかが重要であり、企業が取り組むべきさまざまな課題があります。

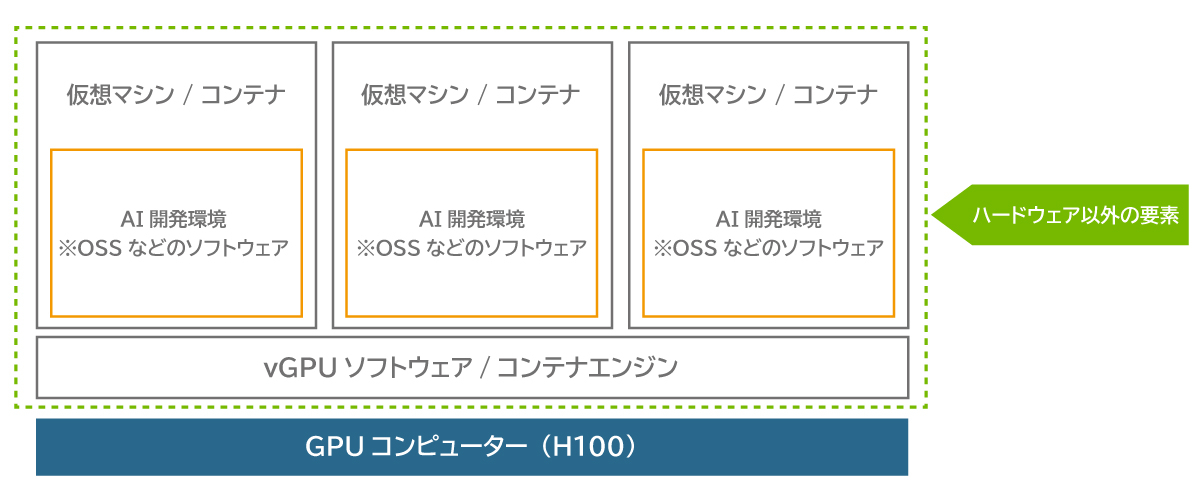

開発環境および本番環境として、ハードウェアに加え、ミドルウェアおよびソフトウェアも整備する必要があります。例えばGPUドライバやコンテナエンジン、AIモデルライブラリなどです。

開発環境の構成図

AIモデルが大規模になると、オンプレミスだけでなく(パブリック)クラウドも含めたマルチプラットフォームで稼働させるために、システムの展開が容易なコンテナ技術が用いられます。まずコンテナを構築したあとで、目的に応じた機械学習ライブラリをはじめとするソフトウェアをコンテナ上にインストールします。AIアプリケーションはさまざまなライブラリを組み合わせて構成されるため、コンテナごとに必要なものを全て適切にインストールし、管理しなければならないのは非常に大変です。

上で述べた通り、AIアプリケーションはさまざまなライブラリで構成され、お互いが複雑な依存関係を持っています。ライブラリは基本的にOSSのためサポートはセルフサービスで、自社で全て対処しなければいけません。一つのOSSがバージョンアップされるたびに、依存関係を調査し、アプリケーション全体への影響を検証するといった、継続的な監視・更新が必要なため、運用工数がかかります。

個々の開発者がアプリケーションごとに複数のOSSを利用するため、セキュリティの脆弱性も増大します。OSSはこのようなリスクも含めて自己責任なので、企業は独自にCVE(Common Vulnerabilities and Exposures:共通脆弱性識別子)スキャンなどで最新のリスク状況を把握したうえで、検知された脆弱性の影響度・対応の優先度を判断し、迅速かつ適切な対策を講じる必要があります。

これまで述べてきた環境構築とセキュリティを担保した継続運用を実現するには、高度な専門知識が必要です。目的とするAIアプリケーションを開発・利活用するにあたって、どんなリソース(ハードウェア、ソフトウェア、ネットワークなど)が必要なのか。それだけでなく、データを学習用に加工する前処理工程でも、また完成したAIアプリケーションを実際に利用するための本番環境を展開するにも、それぞれ専門知識が求められます。

企業が独自に、さまざまなリソースを複雑に組み合わせ、システムを一から構築して最大限の性能を発揮させ、効率的に運用することは、非常に高いハードルと言えます。

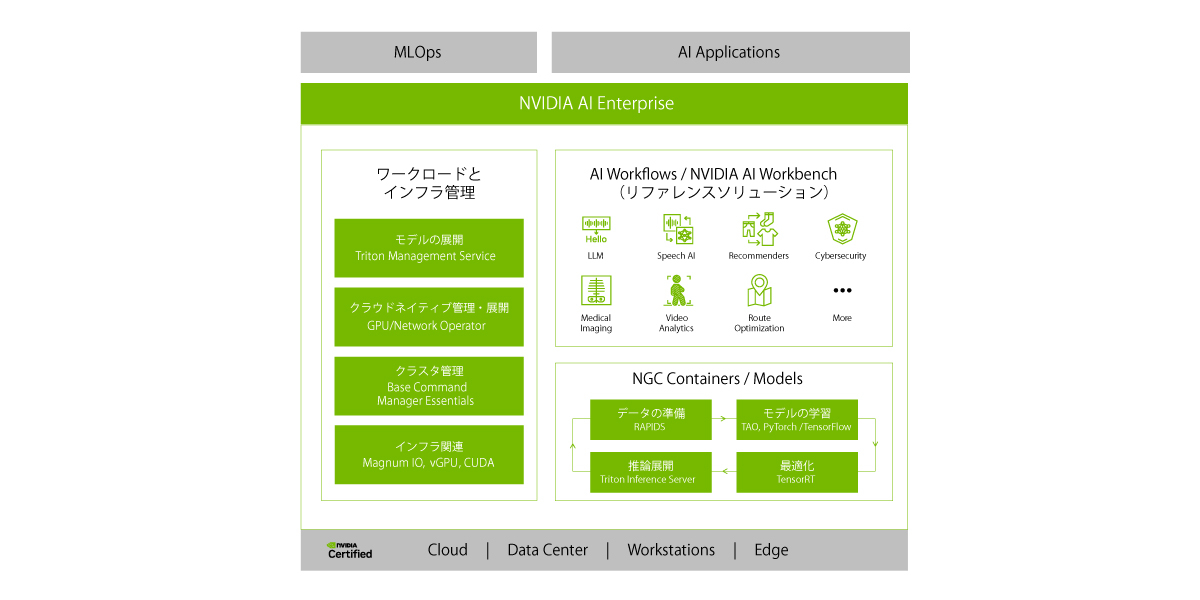

上記の課題を解決し、あらゆる企業におけるAIアプリケーションの開発・利活用(=「AIの民主化」)を加速するのが、「NVIDIA AI Enterprise(以下、AI Enterprise)」と呼ばれるソフトウェア・パッケージです。

NVIDIA AI Enterpriseの全体像(出典:NVIDIA)

AI Enterpriseでは、NVIDIA社が最適化したAI用ソフトウェア群をすぐに使えるかたちで提供しています。それらのソフトウェアは、オンプレミスからクラウドまで、DGXをはじめ認定されたプラットフォーム上で高いパフォーマンスを発揮することが保証されており、H100にももちろん対応しています。ユーザーはAI Enterpriseを通し、環境の整備から、開発、デプロイ、運用までを幅広くサポートする、さまざまなツールを利用することができます。

具体的に、AI Enterpriseはこれらの要素で構成されています。

物理的なGPUリソースを分割して仮想マシン毎に割り当てるvGPUソフトウェア(※)のほか、主要なコンテナエンジン(UbuntuやRed Hat Enterprise Linuxなど)およびコンテナオーケストレーションツール(Red Hat OpenShiftやVMWare Tanzuなど)がすぐにインストールできるようになっています。そのため、開発および実行に必要なインフラを迅速に整備・管理できます。

※vGPUについて詳しく知りたい方はこちらの製品サイトをご覧ください

NVIDIA 仮想GPU(vGPU)| NVIDIA GPU Solution | SCSK株式会社

「NGC Container」とは、ディープラーニングフレームワーク、機械学習アルゴリズム、およびHPCアプリケーションのためのコンテナをパッケージ化したものです。ディープラーニング推論用のSDK「TensorRT」や、生成AIアプリケーション用のマイクロサービス「NIM(NVIDIA Inference Microservice)(※)」といった、NVIDIA社が独自に開発したものに加え、「PyTorch」や「Tensorflow」などのOSSも含まれています。

※NIMについてはこちらの記事でもご紹介しています。

NVIDIA GTC 2024イベントレポート ~Keynote(基調講演)から見る生成AIの世界~|SCSK IT Platform Navigator

NGC Containerで提供されるコンテンツはNVIDIA社によって原則毎月アップデートされているため、ユーザーは常に最新のバージョンを利用できます。パフォーマンスが最大化されるだけでなく、適切に保証されているため、OSS由来のセキュリティリスクも管理しやすく、運用工数やセキュリティの課題解決が期待できます。

「NVIDIA AI Workflows」は、LLMや画像認識、経路最適化などのAIモデルの実装例をまとめたものです。特定のAIタスクやユースケースに沿って、初めからサンプルコードが実装されているため、手元のデータを使ってすぐにアプリケーションを試用できます。開発したいシステムに近い実装例があれば、自分たちのニーズに合わせてそれらを微調整して使うこともできるので、初心者でも利用しやすく、一から開発するのに比べて圧倒的な時間短縮が可能になります。

さらに、開発者向けの統合開発環境である「NVIDIA AI Workbench」があります。AIモデルを作成・トレーニング・デプロイするためのオールインワンツールとして、開発者を支援するさまざまなパッケージが整備されています。例えば、データのクリーニングやラベリングといった学習用データの作成を簡易化するツールや、完成したモデルをエッジデバイスやクラウドにデプロイするツール、複数のメンバー間でデータやモデルを共有するツールなどがあります。

NVIDIA AI WorkflowsおよびNVIDIA AI Workbenchを活用することで、開発者のスキルに依存せず、AIプロジェクトに必要な環境整備、開発、展開を迅速かつ容易に進めることができます。

NVIDIA AI Enterpriseのまとめ

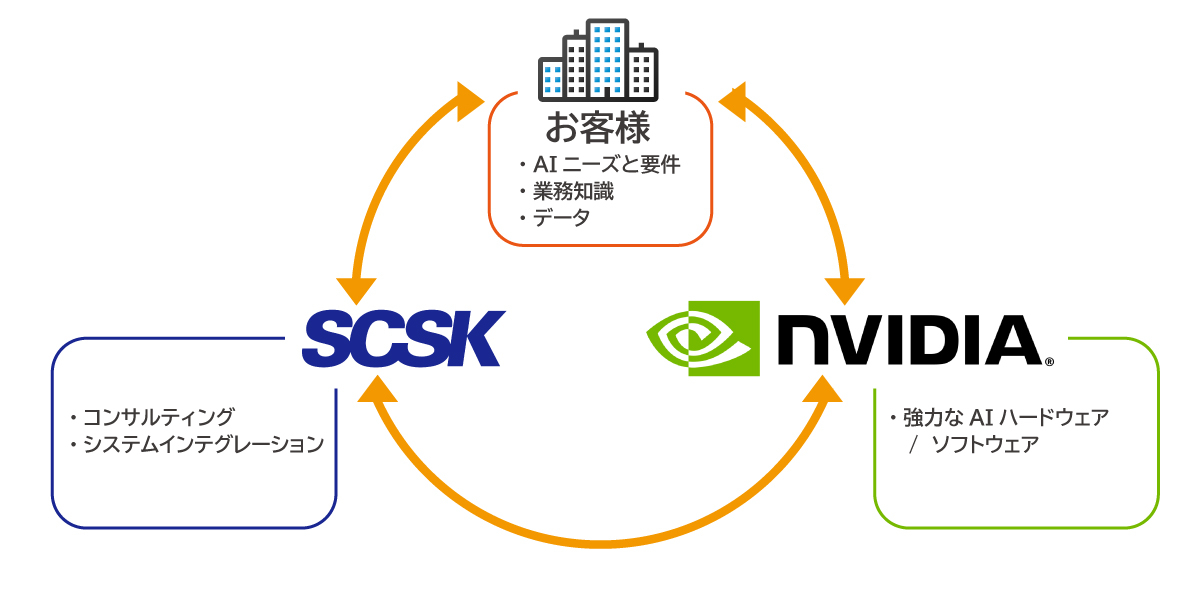

それでは、SCSKがなぜLINK SQUAREにH100を検証機として導入したのかという本題に戻りましょう。それはずばり、LINK SQUAREという共創の場でAIプロジェクトに必要な基盤を広く提供し、企業とNVIDIA社、およびSCSKが共創することによって、ビジネスにおけるさまざまなかたちのAI活用を促進するためです。

SCSK LINK SQUAREを通した共創のかたち

これまで、DGXプラットフォームの中でも高いAI処理性能を誇るH100と、それに対応してAIアプリケーションの開発、展開、運用をトータルでサポートするAI Enterpriseを紹介しました。しかし企業の中には、「いきなりH100などのスーパーコンピュータを導入するのはハードルが高い」「社内にデータサイエンティストなどの専門家がいない(AIに関する知見が不十分)」「AIを活用したいが、何から着手すればよいか分からない」といったお悩みから、なかなかAIプロジェクトの推進に積極的になれないという声も少なくありません。

2018年のとある調査で発表された企業におけるAIの導入状況を見ると、何らかのかたちで導入していると答えた企業の割合は、日本が39%と対象7か国の中で最も低い結果となっています。新たな領域に自社だけで踏み出すハードルは高く、まだまだAI活用に向けた支援の余地が残っていると考えられます。

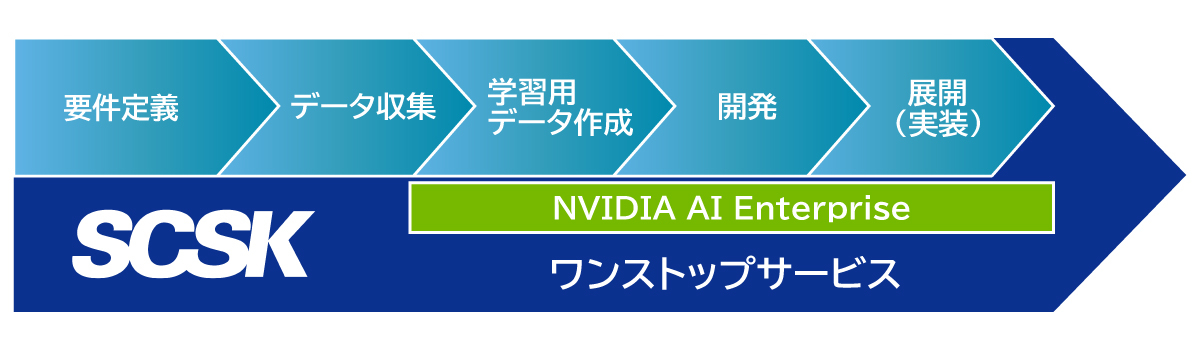

そこでSCSKは、LINK SQUAREを日本のAIプロジェクトの拠点に位置づけ、企業に対し、GPUコンピュータを気軽に試せる検証機としてH100を提供します。さらにAI分野のリーディングカンパニーであるNVIDIA社と協力し、「まずはやってみたい」というお客様の第一歩から、実務への導入・運用までをトータルに支援します。具体的には、

など、SCSKがこれまで培ってきた、インフラ/仮想化/GPUに関わる技術力、AIノウハウ、サポート力を通して、ニーズに応じたさまざまなサービスをワンストップで提供します。

AIプロジェクトを加速するSCSKのワンストップサービス

開発フェーズを中心にDGXおよびAI Enterpriseを通して提供されるNVIDIA社のサポートをベースに、AIプロジェクトの発足から運用定着までをSCSKが伴走します。とりあえず何かやってみたい、H100の性能を体感したい、といったご要望があれば、まずはお気軽にご相談ください。お手元のデータでどんなことができるのか、お客様のビジネスにAIをどのようなかたちで実装するのがベストなのかを、LINK SQUAREで一緒に検証しましょう。

この記事では、LINK SQUAREにおけるH100の導入を切り口に、NVIDIA社およびSCSKが考えるAIの民主化戦略を調査しました。

AIのビジネス活用をお考えの皆様をLINK SQUAREでお待ちしています。

NVIDIA社の製品情報はこちら