―

AI開発に必要なストレージ基盤とは

―

NetAppのAI開発基盤向けソリューションで

開発サイクルを加速し高いROIを実現

IT専門調査会社 IDC Japan 株式会社が、2023年9月26日に発表した「最新のAIシステム市場における産業分野別/ユースケース別の予測」(※1)によると、AIシステム市場のグローバル支出額市場規模は2023年に前年比29.3%増の1,665億米ドルに達すると予測し、国内市場においても前年比31.4%増の6,837億円に達するとしています。

しかしAI開発は一朝一夕に取り組むことが困難ともいえます。その理由はデータです。AI開発の基本的な流れとしては、①データの効率的な収集と蓄積、②目的に応じたデータ処理、③処理結果の出力といったプロセスが必要です。特に①のデータ収集においては自社内に蓄積しているデータのみならず、インターネット上に公開されている情報や開発に必要な特定情報など外部に存在するデータも含めて、膨大なデータを収集・蓄積・連携することが必要になります。それがAI開発の精度実現に直結するからです。

そうしたAI開発基盤の構築においては、MLOps(※2)を効率的に実践する高い計算能力を備えたGPU(画像処理専用プロセッサ)搭載サーバが必須ですが、それと同様に重要なのはAI開発に必要な膨大なビッグデータを保存・運用できる高性能なストレージの存在です。

では、AI開発基盤に必要なストレージインフラとはどのようなものでしょうか。SCSKでは実際にお客様のご要望をまとめてみました。

このように、ストレージは高性能であることはもちろんですが、AI開発者がモデル開発に集中でき、インフラ管理・運用の手間を削減できるシステムを望んでいることが浮き彫りとなりました。

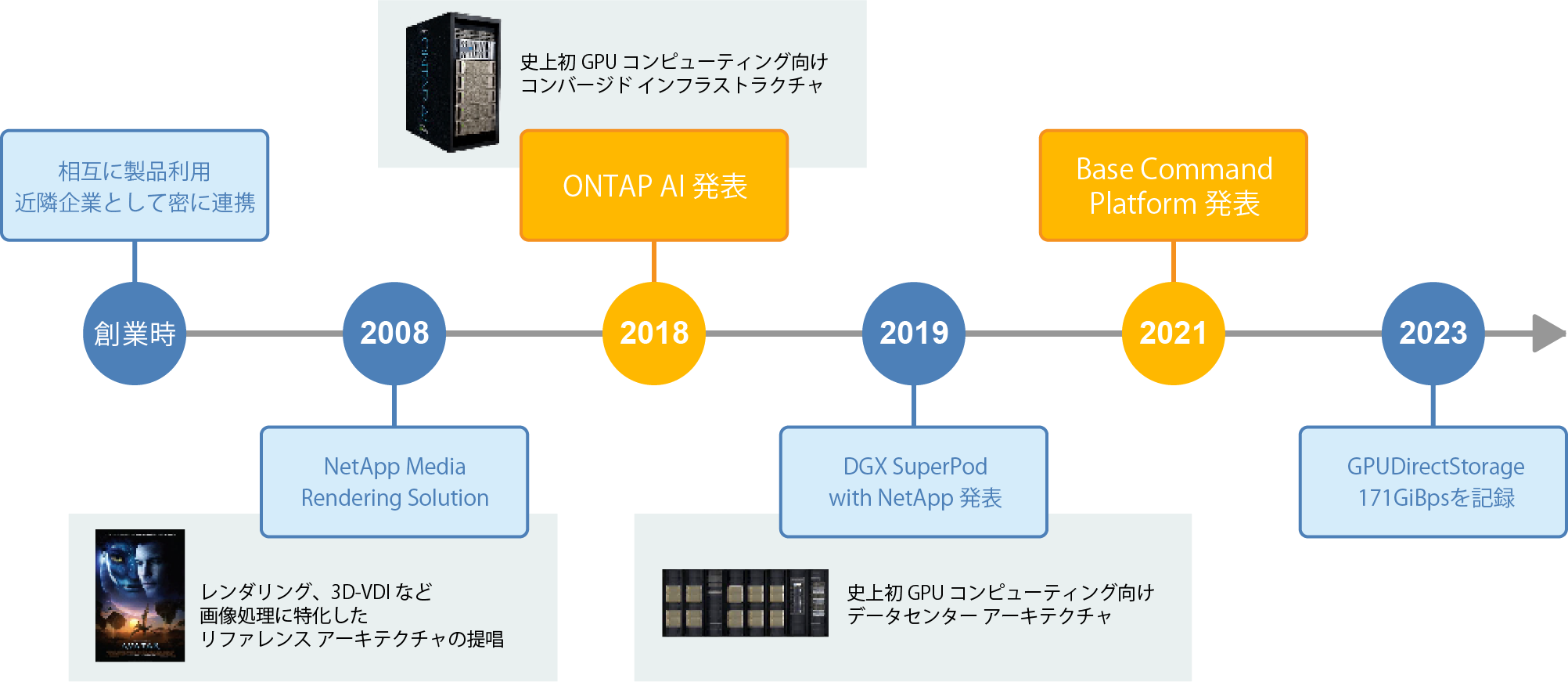

SCSKでは、AI開発基盤としてNetAppの「AI開発基盤向けソリューション」をお勧めしています。NetAppはエンタープライズクラスのストレージサービスで有名ですが、2019年から7つのAIアワードを受賞するなど、数百の公開ドキュメントと30人以上の専用AIチームメンバーによる、4年間のAI知見を蓄積しています。また、GPUの最大手NVIDIA社のトップパートナーであり、NVIDIA社との長年の継続的な開発を行ってきた結果、330を超えるワールドワイドのお客様と、前年比50%以上の収益成長を実現している点もポイントといえます。

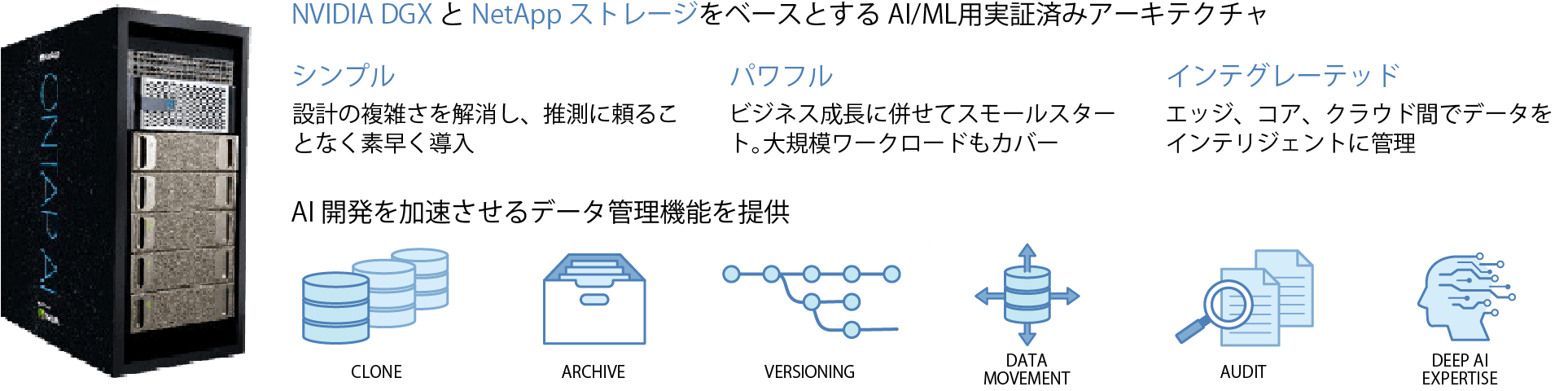

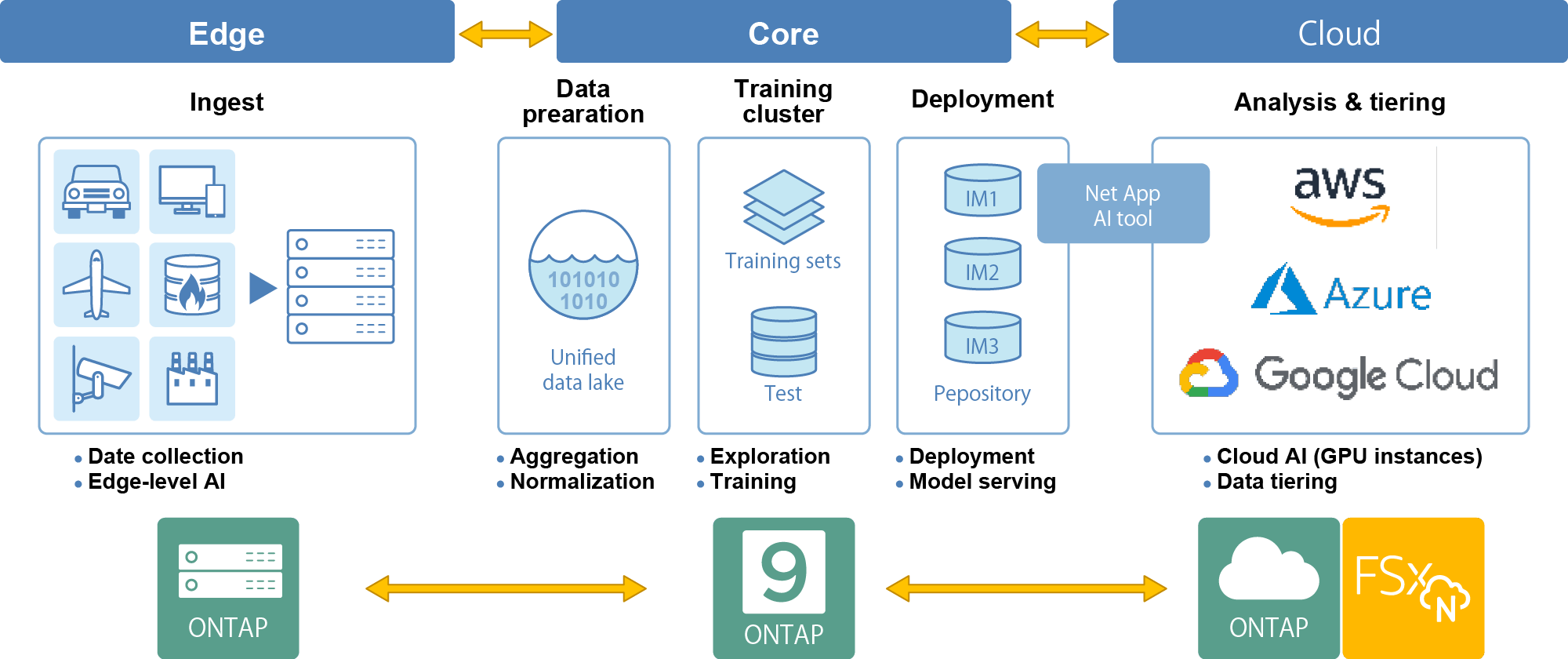

図1:「NetApp ONTAP AI」はデータから真の価値をスムーズに引き出すために開発したAI開発基盤向けソリューション

中でもオンプレミスAI開発基盤向けソリューション「NetApp ONTAP AI」は、クラウドとオンプレミスをシームレスに連携するAI プラットフォーム「NVIDIA DGX」とNetAppストレージをベースとするAI/ML用実証済みアーキテクチャを採用。設計の複雑さを解消して素早く導入可能なシンプルさと、ビジネス成長に併せたスモールスタートから大規模ワークロードまでもカバーするパワフルさ、そしてエッジ~コア~クラウド間でデータをインテリジェントに管理できるインテグレーテッド性能を併せ持つことで、AI開発を加速させるデータ管理機能を提供します。

図2: NetAppの「AI開発基盤向けソリューション」は、Edge/Core/CloudのAIデータパイプライン全体において、ハードウェアとソフトウェアの両面から様々な付加価値を提供可能

NetAppのAI開発基盤向けソリューションは、以下のようなLLM/生成AI開発時のストレージにおける5つの課題を解決します。

これまでは複数のGPUサーバからの処理によってストレージ性能がボトルネックになっていましたが、GPU性能をフルに引き出す高速I/Oによってスループットを171GiB/s 実現しました(NVIDIA「Magnum IO GPUDirect Storage」使用時)。

AIの説明可能性を確保するため、モデルと併せてテラバイトクラスのデータセットも容量消費せずにバージョニングが可能です。

データ移動や複製、バージョニングなどの操作は、ストレージの専門知識がなくてもMLOps/パイプラインツールで自動化できます。

オンプレミス環境とクラウド環境の間で高速・効率的かつシームレスにデータ連携するのでボトルネックを発生させません。

トレーニングの度にデータレイクから大量のデータセットをロードしても、「NetApp ONTAP AI」ならばGPUへのデータ移動が不要なため、トレーニング処理時間を大幅に短縮できます。

AI開発にNetAppをご利用いただくことで、MLOpsツール連携による開発サイクルを加速し、データバージョニング、ハイブリッド/マルチクラウド環境におけるデータ連携の効率化、そして高いROI(投資効果)を実現できます。

SCSKが提供する「NetApp ONTAP AI」の詳しい情報については下記のフォームからお問い合わせください。